История вопроса: что такое генеративная модель? | Машинное обучение

Что означает «генеративный» в названии «генеративно-состязательная сеть»?

« Генеративный » описывает класс статистических моделей, который контрастирует с

дискриминационные модели .

Неофициально:

- Генеративные модели могут генерировать новые экземпляры данных.

- Дискриминативные модели различают разные виды данных

экземпляры.

Генеративная модель может генерировать новые фотографии животных, которые выглядят как настоящие

животных, в то время как дискриминационная модель могла бы отличить собаку от кошки. GAN являются

только один вид генеративной модели.

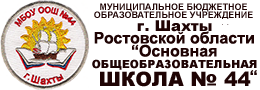

Более формально, учитывая набор экземпляров данных X и набор меток Y:

- Генеративные модели фиксируют совместную вероятность p(X, Y) или просто

p(X), если меток нет. - Дискриминативные модели фиксируют условную вероятность p(Y | X).

Генеративная модель включает в себя распределение самих данных и сообщает вам

насколько вероятен данный пример. Например, модели, которые предсказывают следующее слово в

последовательность обычно представляет собой генеративные модели (обычно намного проще, чем GAN)

потому что они могут присвоить вероятность последовательности слов.

Дискриминационная модель игнорирует вопрос о том, является ли данный экземпляр

скорее всего, и просто говорит вам, насколько вероятно, что метка будет применена к

пример.

Обратите внимание, что это очень общее определение. Существует множество видов генеративных

модель. GAN — это всего лишь один из видов генеративной модели.

Вероятности моделирования

Ни одна из моделей не должна возвращать число, представляющее

вероятность. Вы можете моделировать распределение данных, имитируя

распределение.

Например, дискриминационный классификатор, такой как решение

дерево может помечать экземпляр

без присвоения вероятности этой метке. Такой классификатор по-прежнему будет

Такой классификатор по-прежнему будет

модель, потому что распределение всех предсказанных меток будет моделировать реальную

распределение меток в данных.

Точно так же генеративная модель может моделировать распределение, производя убедительные

«поддельные» данные, которые выглядят так, как будто они взяты из этого дистрибутива.

Генеративные модели сложны

Генеративные модели решают более сложную задачу, чем аналогичные дискриминационные

модели. Генеративные модели должны моделировать больше .

Генеративная модель изображений может фиксировать корреляции, такие как «вещи, которые

похоже, что лодки, вероятно, появятся рядом с вещами, похожими на воду».

и «глаза вряд ли появятся на лбу». Это очень

сложные дистрибутивы.

Напротив, дискриминативная модель могла бы изучить разницу между

«парусник» или «не парусник», просто ища несколько контрольных образцов. Это

может игнорировать многие корреляции, которые генеративная модель должна получить правильно.

Дискриминативные модели пытаются провести границы в пространстве данных, в то время как генеративные

модели пытаются моделировать размещение данных в пространстве. Например,

На следующей диаграмме показаны дискриминационные и генеративные модели рукописного ввода.

цифры:

Рисунок 1: Дискриминационная и генеративная модели рукописных цифр.

Дискриминационная модель пытается определить разницу между написанными от руки нулями

и 1, нарисовав линию в пространстве данных. Если он получает линию правильно, он может

отличать 0 от 1, даже не моделируя, где именно

экземпляры размещаются в пространстве данных по обе стороны от линии.

Напротив, генеративная модель пытается производить убедительные единицы и нули

путем создания цифр, которые близки к их реальным аналогам в данных

космос. Он должен моделировать распределение по всему пространству данных.

GAN предлагают эффективный способ обучения таких богатых моделей, чтобы они походили на настоящие

распределение. Чтобы понять, как они работают, нам нужно понять основные

Чтобы понять, как они работают, нам нужно понять основные

структура ГАН.

Проверьте свое понимание: Генеративный и генеративный

Дискриминативные модели

У вас есть IQ на 1000 человек. Вы моделируете распределение показателей IQ

со следующей процедурой:

- Бросьте три шестигранных кубика.

- Умножить бросок на константу w.

- Повторить 100 раз и взять среднее значение всех результатов.

Вы пробуете разные значения для w, пока результат вашей процедуры не будет равен

средний показатель реального IQ. Ваш

моделировать генеративную модель или дискриминативную модель?

Генеративная модель

Правильно: с каждым броском вы эффективно генерируете IQ

воображаемый человек. Кроме того, ваша генеративная модель фиксирует

тот факт, что показатели IQ распределяются нормально (то есть по кривой нормального распределения).

Дискриминационная модель

Неверно: аналогичная дискриминационная модель попыталась бы различать

между различными видами показателей IQ. Для

Например, дискриминационная модель может попытаться классифицировать IQ как фальшивый или

настоящий.

Недостаточно информации.

Эта модель действительно подходит под определение одного из двух наших видов

модели.

Модель возвращает вероятность, когда вы даете ей экземпляр данных. Это

моделировать генеративную модель или дискриминативную модель?

Генеративная модель

Генеративная модель может оценить вероятность экземпляра и

также вероятность метки класса.

Дискриминационная модель

Дискриминационная модель может оценить вероятность того, что экземпляр

принадлежит классу.

Недостаточно информации.

Как генеративные, так и дискриминационные модели могут оценивать вероятности

(но они не обязаны).

Генеративный подход к смягчению структурных искажений в выводе на естественном языке

Димион Асаэль,

Захари Циглер,

Йонатан Белинков

Abstract

Многие наборы данных вывода на естественном языке (NLI) содержат смещения, которые позволяют моделям работать хорошо, используя только смещенное подмножество входных данных, без учета остальных функций. Например, модели могут классифицировать образцы, используя только гипотезу, не изучая истинную связь между ней и предпосылкой. Эти структурные предубеждения приводят к тому, что дискриминационные модели изучают непреднамеренные поверхностные особенности и плохо обобщают обучающее распределение. В этой работе мы переформулируем задачу NLI как генеративную задачу, где модель обусловлена смещенным подмножеством входных данных и меткой и генерирует оставшееся подмножество входных данных. Мы показываем, что, налагая единый априор, мы получаем доказуемо несмещенную модель. С помощью синтетических экспериментов мы обнаружили, что этот подход очень устойчив к большим смещениям. Затем мы эмпирически демонстрируем на двух типах естественных смещений, что этот подход на практике приводит к полностью беспристрастным моделям. Однако мы обнаружили, что генеративные модели трудно обучать и, как правило, они работают хуже, чем дискриминационные базовые модели. Мы подчеркиваем сложность задачи генеративного моделирования в контексте NLI как причину ухудшения производительности. Наконец, путем точной настройки генеративной модели с целью различения мы уменьшаем разрыв в производительности между генеративной моделью и базовым уровнем различения, допуская при этом небольшую погрешность.

Затем мы эмпирически демонстрируем на двух типах естественных смещений, что этот подход на практике приводит к полностью беспристрастным моделям. Однако мы обнаружили, что генеративные модели трудно обучать и, как правило, они работают хуже, чем дискриминационные базовые модели. Мы подчеркиваем сложность задачи генеративного моделирования в контексте NLI как причину ухудшения производительности. Наконец, путем точной настройки генеративной модели с целью различения мы уменьшаем разрыв в производительности между генеративной моделью и базовым уровнем различения, допуская при этом небольшую погрешность.

- Код антологии:

- 2022.starsem-1.16

- Том:

- Материалы 11-й совместной конференции по лексической и вычислительной семантике

- Месяц:

- Год:

- 2022

- Адрес:

- Сиэтл, Вашингтон

- Место проведения:

- *SEM

- SIG:

- SIGSEM

- Издатель:

- Ассоциация компьютерной лингвистики

- Примечание:

- Страниц:

- 186–199

- Язык:

- URL:

- https://aclanthology.

org/2022.starsem-1.16

org/2022.starsem-1.16 - DOI:

- 10.186 53/v1/2022.starsem-1.16

- Бибключ:

- Процитируйте (ACL):

- Димион Асаэль, Закари Зиглер и Йонатан Белинков. 2022. Генеративный подход к смягчению структурных искажений в выводе естественного языка. В материалах 11-й совместной конференции по лексической и вычислительной семантике , страницы 186–19.9, Сиэтл, Вашингтон. Ассоциация компьютерной лингвистики.

- Процитируйте (неофициально):

- Генеративный подход к смягчению структурных искажений в выводе естественного языка (Асаэль и др., *SEM 2022)

- Копия цитирования:

- PDF:

- https://aclanthology.org/2022.starsem-1.16.pdf

- Код

- technion-cs-nlp/generative-nli

- Данные

901 24 июля

901 24 MultiNLI, SNLI

- BibTeX

- MODS XML

- Конечная сноска

- Предварительно отформатированный

@inproceedings{asael-etal-2022-generative,

title = "Генеративный подход к смягчению структурных искажений в выводе естественного языка",

автор = "Асаэль, Димион и

Циглер, Захари и

Белинков, Йонатан». booktitle = "Материалы 11-й совместной конференции по лексической и вычислительной семантике",

месяц = июль,

год = "2022",

address = "Сиэтл, Вашингтон",

издатель = "Ассоциация вычислительной лингвистики",

url = "https://aclanthology.org/2022.starsem-1.16",

doi = "10.18653/v1/2022.starsem-1.16",

страницы = "186--199",

abstract = «Многие наборы данных вывода на естественном языке (NLI) содержат смещения, которые позволяют моделям работать хорошо, используя только смещенное подмножество входных данных, не учитывая остальные функции. Например, модели могут классифицировать выборки, используя только гипотезу, без изучения истинной взаимосвязи между ней и предпосылкой. Эти структурные предубеждения приводят дискриминационные модели к изучению непреднамеренных поверхностных особенностей и плохому обобщению из обучающего распределения. В этой работе мы переформулируем задачу NLI как генеративную задачу, где модель обусловлена на смещенном подмножестве входных данных и метки и генерирует оставшееся подмножество входных данных.

booktitle = "Материалы 11-й совместной конференции по лексической и вычислительной семантике",

месяц = июль,

год = "2022",

address = "Сиэтл, Вашингтон",

издатель = "Ассоциация вычислительной лингвистики",

url = "https://aclanthology.org/2022.starsem-1.16",

doi = "10.18653/v1/2022.starsem-1.16",

страницы = "186--199",

abstract = «Многие наборы данных вывода на естественном языке (NLI) содержат смещения, которые позволяют моделям работать хорошо, используя только смещенное подмножество входных данных, не учитывая остальные функции. Например, модели могут классифицировать выборки, используя только гипотезу, без изучения истинной взаимосвязи между ней и предпосылкой. Эти структурные предубеждения приводят дискриминационные модели к изучению непреднамеренных поверхностных особенностей и плохому обобщению из обучающего распределения. В этой работе мы переформулируем задачу NLI как генеративную задачу, где модель обусловлена на смещенном подмножестве входных данных и метки и генерирует оставшееся подмножество входных данных. Мы показываем, что, накладывая единый априор, мы получаем доказуемо несмещенную модель.С помощью синтетических экспериментов мы обнаруживаем, что этот подход очень устойчив к большим количествам предвзятости Затем мы эмпирически демонстрируем на двух типах естественного смещения, что этот подход приводит к полностью беспристрастным моделям на практике.Однако мы обнаруживаем, что генеративные модели трудно обучать и обычно они работают хуже, чем дискриминационные базовые модели. Мы подчеркиваем сложность задачи генеративного моделирования в контексте NLI как причину ухудшения производительности. Наконец, путем точной настройки генеративной модели с целью различения мы уменьшаем разрыв в производительности между генеративной моделью и базовым уровнем различения, допуская при этом небольшую погрешность».

}

Мы показываем, что, накладывая единый априор, мы получаем доказуемо несмещенную модель.С помощью синтетических экспериментов мы обнаруживаем, что этот подход очень устойчив к большим количествам предвзятости Затем мы эмпирически демонстрируем на двух типах естественного смещения, что этот подход приводит к полностью беспристрастным моделям на практике.Однако мы обнаруживаем, что генеративные модели трудно обучать и обычно они работают хуже, чем дискриминационные базовые модели. Мы подчеркиваем сложность задачи генеративного моделирования в контексте NLI как причину ухудшения производительности. Наконец, путем точной настройки генеративной модели с целью различения мы уменьшаем разрыв в производительности между генеративной моделью и базовым уровнем различения, допуская при этом небольшую погрешность».

}

<моды> <информация о заголовке> Генеративный подход к смягчению структурных искажений при выводе естественного языка <название типа="личное">Димион Асаэль <роль>автор <название типа="личное">Закари Циглер <роль>автор <название типа="личное">Йонатан Белинков <роль>автор <информация о происхождении>2022-07 текст <информация о заголовке> Материалы 11-й совместной конференции по лексической и вычислительной семантике <информация о происхождении>Ассоциация компьютерной лингвистики <место>Сиэтл, Вашингтон публикация конференции Многие наборы данных вывода на естественном языке (NLI) содержат смещения, которые позволяют моделям работать хорошо, используя только смещенное подмножество входных данных без учета остальных функций. Например, модели могут классифицировать образцы, используя только гипотезу, не изучая истинную связь между ней и предпосылкой. Эти структурные предубеждения приводят к тому, что дискриминационные модели изучают непреднамеренные поверхностные особенности и плохо обобщают обучающее распределение. В этой работе мы переформулируем задачу NLI как генеративную задачу, где модель обусловлена смещенным подмножеством входных данных и меткой и генерирует оставшееся подмножество входных данных. Мы показываем, что, налагая единый априор, мы получаем доказуемо несмещенную модель. С помощью синтетических экспериментов мы обнаружили, что этот подход очень устойчив к большим смещениям. Затем мы эмпирически демонстрируем на двух типах естественных смещений, что этот подход на практике приводит к полностью беспристрастным моделям. Однако мы обнаружили, что генеративные модели трудно обучать и, как правило, они работают хуже, чем дискриминационные базовые модели. Мы подчеркиваем сложность задачи генеративного моделирования в контексте NLI как причину ухудшения производительности.

Наконец, путем точной настройки генеративной модели с целью различения мы уменьшаем разрыв в производительности между генеративной моделью и базовым уровнем различения, допуская при этом небольшую погрешность.

asael-etal-2022-generative 10.18653/v1/2022.starsem-1.16 <местоположение>https://aclanthology.org/2022.starsem-1.16 <часть> <дата>2022-07 <единица экстента="страница">186 <конец>199

%0 Материалы конференции

%T Генеративный подход к смягчению структурных искажений в выводе естественного языка

%А Асаэль, Димион

%А Циглер, Захари

%А Белинков, Йонатан

%S Материалы 11-й совместной конференции по лексической и вычислительной семантике

%D 2022

%8 июля

%I Ассоциация компьютерной лингвистики

%C Сиэтл, Вашингтон

%F asael-etal-2022-generative

%X Многие наборы данных вывода на естественном языке (NLI) содержат смещения, которые позволяют моделям работать хорошо, используя только смещенное подмножество входных данных, без учета остальных функций.Например, модели могут классифицировать образцы, используя только гипотезу, не изучая истинную связь между ней и предпосылкой. Эти структурные предубеждения приводят к тому, что дискриминационные модели изучают непреднамеренные поверхностные особенности и плохо обобщают обучающее распределение. В этой работе мы переформулируем задачу NLI как генеративную задачу, где модель обусловлена смещенным подмножеством входных данных и меткой и генерирует оставшееся подмножество входных данных. Мы показываем, что, налагая единый априор, мы получаем доказуемо несмещенную модель. С помощью синтетических экспериментов мы обнаружили, что этот подход очень устойчив к большим смещениям. Затем мы эмпирически демонстрируем на двух типах естественных смещений, что этот подход на практике приводит к полностью беспристрастным моделям. Однако мы обнаружили, что генеративные модели трудно обучать и, как правило, они работают хуже, чем дискриминационные базовые модели. Мы подчеркиваем сложность задачи генеративного моделирования в контексте NLI как причину ухудшения производительности.

org/2022.starsem-1.16

org/2022.starsem-1.16 booktitle = "Материалы 11-й совместной конференции по лексической и вычислительной семантике",

месяц = июль,

год = "2022",

address = "Сиэтл, Вашингтон",

издатель = "Ассоциация вычислительной лингвистики",

url = "https://aclanthology.org/2022.starsem-1.16",

doi = "10.18653/v1/2022.starsem-1.16",

страницы = "186--199",

abstract = «Многие наборы данных вывода на естественном языке (NLI) содержат смещения, которые позволяют моделям работать хорошо, используя только смещенное подмножество входных данных, не учитывая остальные функции. Например, модели могут классифицировать выборки, используя только гипотезу, без изучения истинной взаимосвязи между ней и предпосылкой. Эти структурные предубеждения приводят дискриминационные модели к изучению непреднамеренных поверхностных особенностей и плохому обобщению из обучающего распределения. В этой работе мы переформулируем задачу NLI как генеративную задачу, где модель обусловлена на смещенном подмножестве входных данных и метки и генерирует оставшееся подмножество входных данных.

booktitle = "Материалы 11-й совместной конференции по лексической и вычислительной семантике",

месяц = июль,

год = "2022",

address = "Сиэтл, Вашингтон",

издатель = "Ассоциация вычислительной лингвистики",

url = "https://aclanthology.org/2022.starsem-1.16",

doi = "10.18653/v1/2022.starsem-1.16",

страницы = "186--199",

abstract = «Многие наборы данных вывода на естественном языке (NLI) содержат смещения, которые позволяют моделям работать хорошо, используя только смещенное подмножество входных данных, не учитывая остальные функции. Например, модели могут классифицировать выборки, используя только гипотезу, без изучения истинной взаимосвязи между ней и предпосылкой. Эти структурные предубеждения приводят дискриминационные модели к изучению непреднамеренных поверхностных особенностей и плохому обобщению из обучающего распределения. В этой работе мы переформулируем задачу NLI как генеративную задачу, где модель обусловлена на смещенном подмножестве входных данных и метки и генерирует оставшееся подмножество входных данных. Мы показываем, что, накладывая единый априор, мы получаем доказуемо несмещенную модель.С помощью синтетических экспериментов мы обнаруживаем, что этот подход очень устойчив к большим количествам предвзятости Затем мы эмпирически демонстрируем на двух типах естественного смещения, что этот подход приводит к полностью беспристрастным моделям на практике.Однако мы обнаруживаем, что генеративные модели трудно обучать и обычно они работают хуже, чем дискриминационные базовые модели. Мы подчеркиваем сложность задачи генеративного моделирования в контексте NLI как причину ухудшения производительности. Наконец, путем точной настройки генеративной модели с целью различения мы уменьшаем разрыв в производительности между генеративной моделью и базовым уровнем различения, допуская при этом небольшую погрешность».

}

Мы показываем, что, накладывая единый априор, мы получаем доказуемо несмещенную модель.С помощью синтетических экспериментов мы обнаруживаем, что этот подход очень устойчив к большим количествам предвзятости Затем мы эмпирически демонстрируем на двух типах естественного смещения, что этот подход приводит к полностью беспристрастным моделям на практике.Однако мы обнаруживаем, что генеративные модели трудно обучать и обычно они работают хуже, чем дискриминационные базовые модели. Мы подчеркиваем сложность задачи генеративного моделирования в контексте NLI как причину ухудшения производительности. Наконец, путем точной настройки генеративной модели с целью различения мы уменьшаем разрыв в производительности между генеративной моделью и базовым уровнем различения, допуская при этом небольшую погрешность».

}

Например, модели могут классифицировать образцы, используя только гипотезу, не изучая истинную связь между ней и предпосылкой. Эти структурные предубеждения приводят к тому, что дискриминационные модели изучают непреднамеренные поверхностные особенности и плохо обобщают обучающее распределение. В этой работе мы переформулируем задачу NLI как генеративную задачу, где модель обусловлена смещенным подмножеством входных данных и меткой и генерирует оставшееся подмножество входных данных. Мы показываем, что, налагая единый априор, мы получаем доказуемо несмещенную модель. С помощью синтетических экспериментов мы обнаружили, что этот подход очень устойчив к большим смещениям. Затем мы эмпирически демонстрируем на двух типах естественных смещений, что этот подход на практике приводит к полностью беспристрастным моделям. Однако мы обнаружили, что генеративные модели трудно обучать и, как правило, они работают хуже, чем дискриминационные базовые модели. Мы подчеркиваем сложность задачи генеративного моделирования в контексте NLI как причину ухудшения производительности.

Например, модели могут классифицировать образцы, используя только гипотезу, не изучая истинную связь между ней и предпосылкой. Эти структурные предубеждения приводят к тому, что дискриминационные модели изучают непреднамеренные поверхностные особенности и плохо обобщают обучающее распределение. В этой работе мы переформулируем задачу NLI как генеративную задачу, где модель обусловлена смещенным подмножеством входных данных и меткой и генерирует оставшееся подмножество входных данных. Мы показываем, что, налагая единый априор, мы получаем доказуемо несмещенную модель. С помощью синтетических экспериментов мы обнаружили, что этот подход очень устойчив к большим смещениям. Затем мы эмпирически демонстрируем на двух типах естественных смещений, что этот подход на практике приводит к полностью беспристрастным моделям. Однако мы обнаружили, что генеративные модели трудно обучать и, как правило, они работают хуже, чем дискриминационные базовые модели. Мы подчеркиваем сложность задачи генеративного моделирования в контексте NLI как причину ухудшения производительности. Наконец, путем точной настройки генеративной модели с целью различения мы уменьшаем разрыв в производительности между генеративной моделью и базовым уровнем различения, допуская при этом небольшую погрешность.

Наконец, путем точной настройки генеративной модели с целью различения мы уменьшаем разрыв в производительности между генеративной моделью и базовым уровнем различения, допуская при этом небольшую погрешность. Например, модели могут классифицировать образцы, используя только гипотезу, не изучая истинную связь между ней и предпосылкой. Эти структурные предубеждения приводят к тому, что дискриминационные модели изучают непреднамеренные поверхностные особенности и плохо обобщают обучающее распределение. В этой работе мы переформулируем задачу NLI как генеративную задачу, где модель обусловлена смещенным подмножеством входных данных и меткой и генерирует оставшееся подмножество входных данных. Мы показываем, что, налагая единый априор, мы получаем доказуемо несмещенную модель. С помощью синтетических экспериментов мы обнаружили, что этот подход очень устойчив к большим смещениям. Затем мы эмпирически демонстрируем на двух типах естественных смещений, что этот подход на практике приводит к полностью беспристрастным моделям. Однако мы обнаружили, что генеративные модели трудно обучать и, как правило, они работают хуже, чем дискриминационные базовые модели. Мы подчеркиваем сложность задачи генеративного моделирования в контексте NLI как причину ухудшения производительности.

Например, модели могут классифицировать образцы, используя только гипотезу, не изучая истинную связь между ней и предпосылкой. Эти структурные предубеждения приводят к тому, что дискриминационные модели изучают непреднамеренные поверхностные особенности и плохо обобщают обучающее распределение. В этой работе мы переформулируем задачу NLI как генеративную задачу, где модель обусловлена смещенным подмножеством входных данных и меткой и генерирует оставшееся подмножество входных данных. Мы показываем, что, налагая единый априор, мы получаем доказуемо несмещенную модель. С помощью синтетических экспериментов мы обнаружили, что этот подход очень устойчив к большим смещениям. Затем мы эмпирически демонстрируем на двух типах естественных смещений, что этот подход на практике приводит к полностью беспристрастным моделям. Однако мы обнаружили, что генеративные модели трудно обучать и, как правило, они работают хуже, чем дискриминационные базовые модели. Мы подчеркиваем сложность задачи генеративного моделирования в контексте NLI как причину ухудшения производительности.